这个年头,不仅打工人没有闲着,就连AI也加入了内卷的行列。

近日,发表在《国际市场营销研究杂志》上的一篇文章显示,美国达特茅斯学院和印第安纳大学的研究人员研发了一个人工智能系统。

它不仅能为电商产品撰写评论,而且写出的评论还充满可人情味儿,让人根本无法分辨这文笔究竟出自人类还是AI。

这项研究一经问世,立即引发了热烈的讨论。

随着科技的迅速发展,人工智能的学习能力越来越强,和人类的差异越来越小,而关于人工智能终会取代人类的悲观叙事也显得越来越顺理成章。

工智能是否会取代人类,我们不得而知,但人们关于研究人工智能的争议逐渐多了起来。而近几年,争议主要聚焦在以下几个方面。

01

AI把我们变成了透明人?

通过多年的积累,科技公司收集了大量消费者的个人信息,并在此基础上进行营销和广告投放。

通过分析同一地域的消费者在网上留下的信息,科技公司可以预测出到底什么样的电视节目可以吸引消费者的目光,或者什么品牌的狗粮可能成为消费者的第一选择。

机器学习更强化了科技公司提取消费者标签和预测消费者喜好的能力。

机器学习可以分析用户的在线行为。网络用户的政治信仰、宗教信仰、种族、健康状况、性别和性取向全都无处遁形。

似乎有一个隐形的数字福尔摩斯,对每个进入网络空间的人进行从头到脚的推理判断。

毫不夸张的说,在AI面前,我们都变成了透明人。

今日,一款名为“gayface”的实验性面部识别软件更加引发了人们对AI侵犯个人隐私的担忧。

研发者对软件的智能识别人脸的功能上进行了升级,声称它可以通过面部特征推测用户的性取向。

“gayface”一旦面世,意味着人们生活中最私密和敏感的方面也逃不过AI的审查。

在AI面前,我们真的还有隐私可言吗?

02

社会固有偏见遇上算法,会擦出怎样的火花?

科幻电影《少年派报告》中的“先知”能侦察出人的犯罪企图,在罪犯犯罪之前,“先知”就能通知“犯罪预防组织”的警察前来将其逮捕。

如今,这一科幻场景已然照进了现实。

在一些国家,算法预测已经被应用于司法系统,用来设定保释金,确定刑期,并通过风险评估算法估计罪犯再犯的可能性。

用人工智能为司法决策提供详细的算法帮助,这看起来似乎对司法系统有很大助益。然而,司法的AI化对人类来说究竟是福报还是厄运仍然很难断言。

ProPublica的一份调查报告显示,这些算法在实际应用中往往被加深了种族偏见,使得黑人被告被标记为潜在罪犯的比率是白人被告两倍之多。

机器学习模型的可靠性与基础数据和寻找、组织、标记数据的每一个步骤都密切相关。

倘若基础数据带有偏见,那么,结构性不平等和社会固有偏见就有可能被成倍放大,产生难以预料的后果。

03

让AI更有人情味儿

2018年10月,国际数据保护和隐私专员会议发布了《人工智能伦理与保护宣言》,该宣言指出:"应该有效地减少因人工智能基础数据而导致的非法偏见或歧视”。

要想达成这一目标,首先要最大化地提升数据集的代表性并保护弱势群体。

将代表性不足的人群加入更多数据集当中,把有偏见的机器学习模型置于不同数据源中进行反复多次的训练,以及用新的算法技术衡量错误的代表性都是行之有效的方法。

除此之外,机器学习模型也需要避免对人类产生不公正的影响。

实际上,“gayface”的出现恰好提醒我们,性取向和性别认同应与种族、国籍、宗教和政治信仰一起成为受保护的特征,而这一点也需要在法律中加以体现。

人工智能是一把双刃剑,然而,利用它的方式还是掌握在人类自己手中。

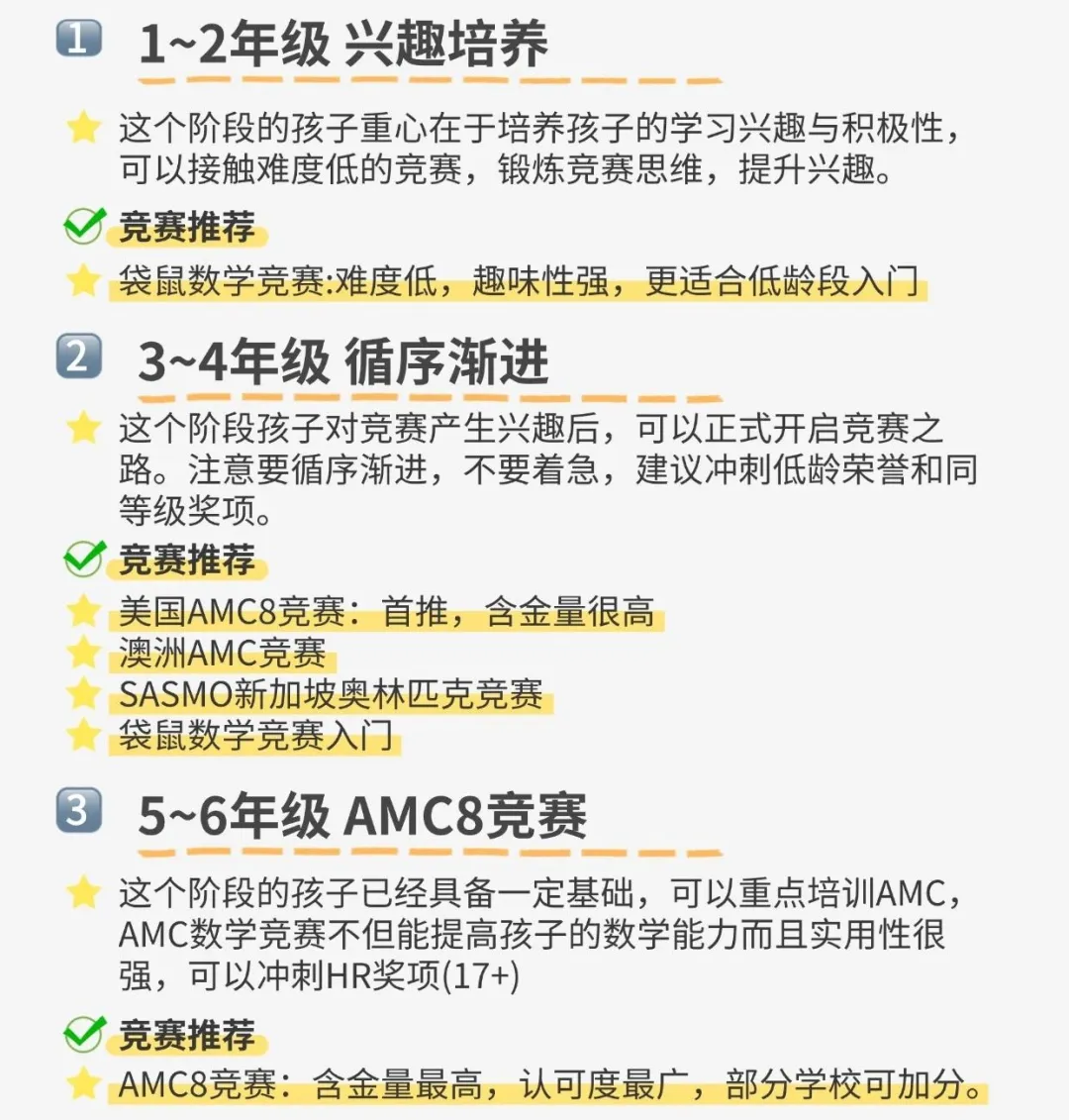

今后,对于人工智能的研究、开发与利用,还需要一代又一代的专业人才贡献自己的智慧与力量。