ChatGPT的强大真的惊艳到了几乎所有人,反应最快的可能就是科研圈的小伙伴,毕竟他们距离技术最近,近水楼台嘛。

很多人拿到这个工具的第一反应可能是,可不可以写论文?

不过,有道是魔高一尺,道高一尺二,为了防止大家像我想的这样“走捷径”,人们很快研发了很多方法用来区分文本是由人工智能还是人类创作的内容。

但是,随着更多的人关注GPT检测器,有一个对我们这些英语非母语的科研人员十分不利的消息——GPT检测器经常将英语非母语作者的样本错误分类为AI生成的。下面,我们首先来看看GPT检测器是怎么回事。

用AI打败AI——GPT检测器

现在检测机器生成文本的检测器已经越来越多,既有OpenAI自家开发的AI Text Classifier,也有GPTZero、Originality.AI、ZeroGPT等等,而且还不断地有针对检测器的研究发布。

这些检测器有的基于深度学习方法,有的基于机器学习方法。比如基于统计特征的检测器,使用语言模型困惑度(perplexity,ppl)、突发性(burstiness)这样的统计特征,来进行逻辑回归,判断文本是否由机器生成。

这些统计特征往往基于生成语言模型的一些特征,比如很火的GPTZero[1],就是基于困惑度和突发性。简而言之,困惑度是一种度量随机性的参数,而突发性则是度量句子复杂度的。如果文本随机性和突发性比较高,那么它就更可能是由人类写出来的,比如人类的文章仿佛起起落落的海浪,一句一句话有长有短,而AI往往有一个恒定的基线。(当然,AI的迭代之快速,这个小漏洞不知道会不会很快被攻克)。

其实,大多数检测器的检测原理都是基于类似的逻辑——我们通常认为人类创作的文本没有AI创作的“稳定”。比如GLTR[2]工具,就是基于语言生成模型解码阶段的“总是选择预测的概率较高的词输出”的特点来进行检测。下一个词总是预测概率较高的词,这很AI,很不人类。但是,用AI来打败AI显然没有那么容易。误伤无处不在。

根据今年4月份的一篇研究[3]显示,检测器有一定概率把人类写出的文章错误的判断成了AI的“产品”——

有偏见的误伤

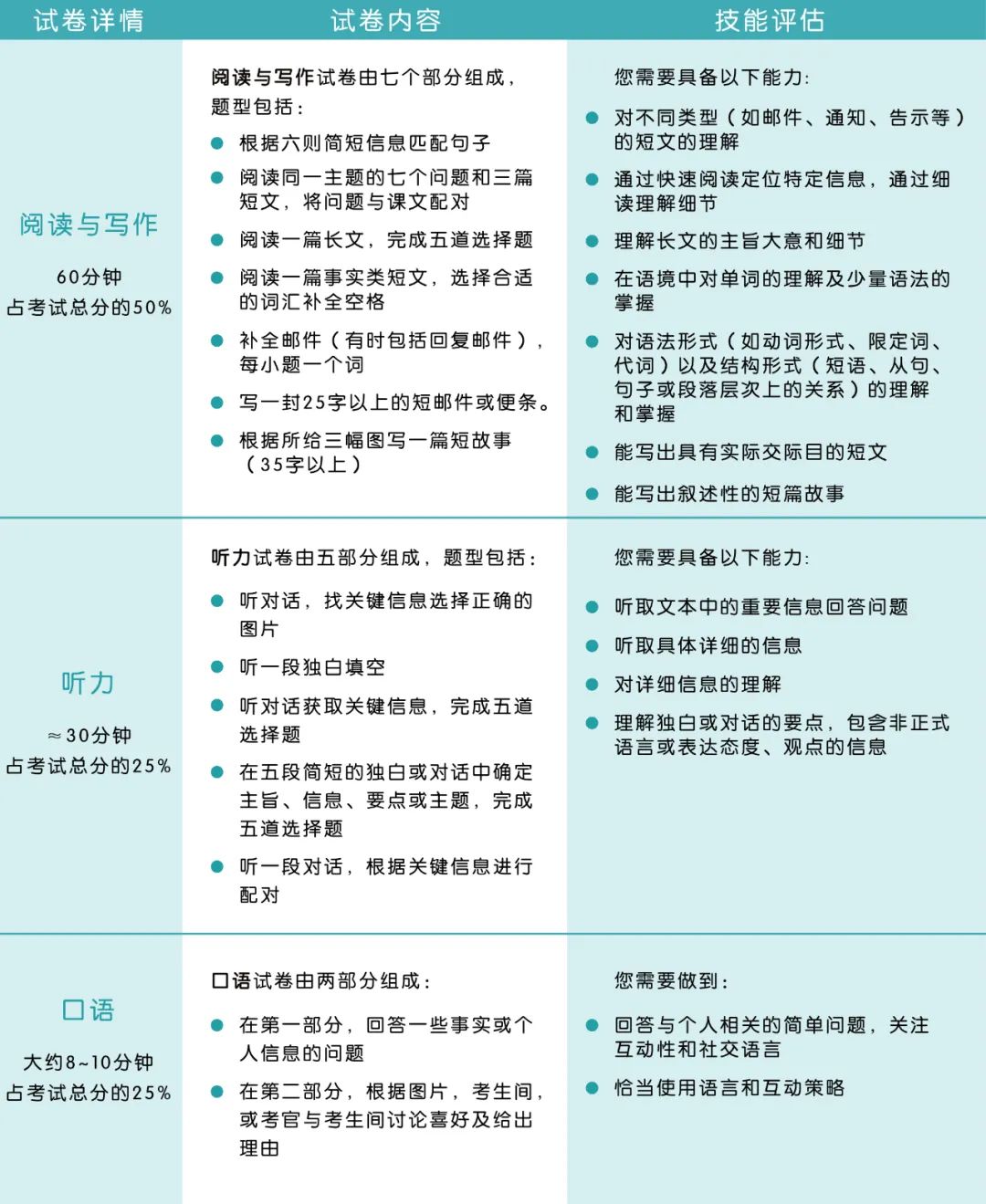

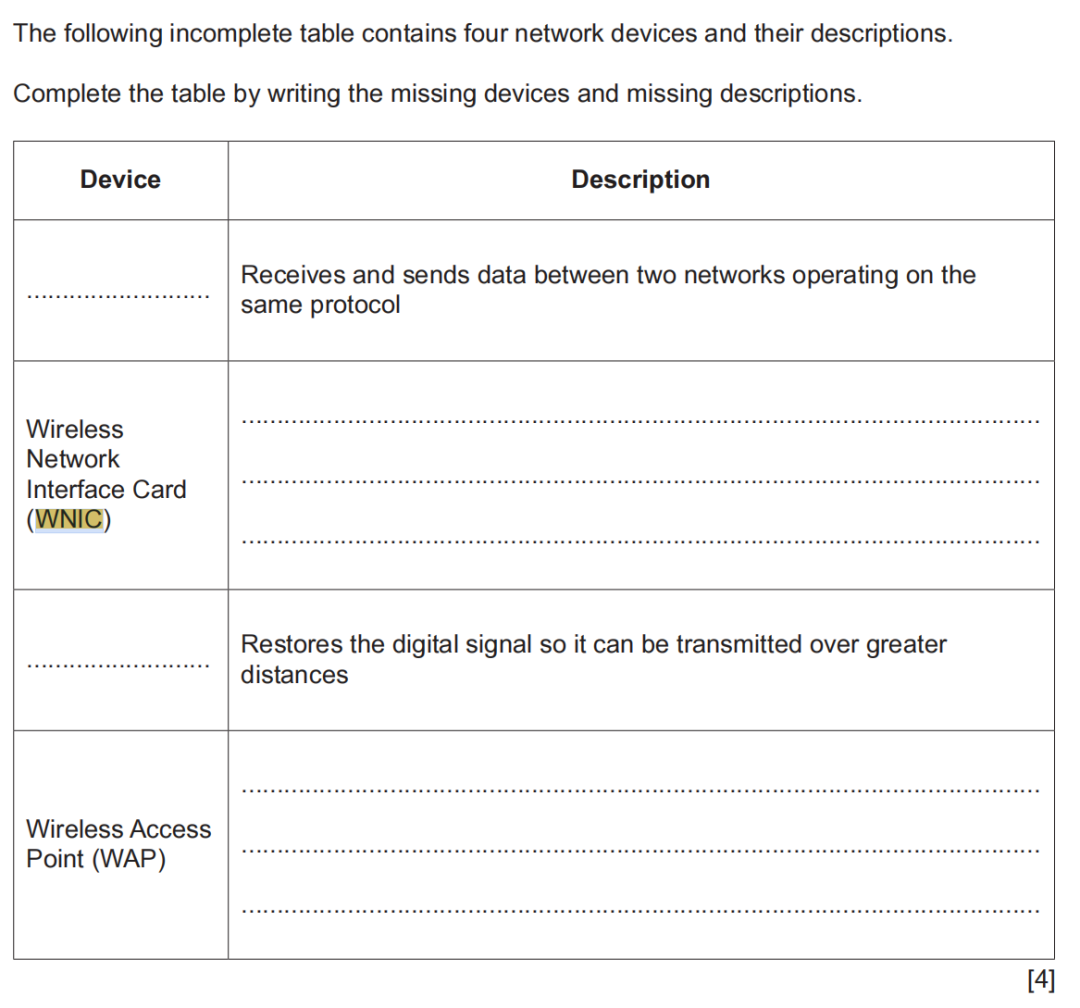

上面这幅图很有趣也很残酷,图上列举了7个GPT检测器。它们分别检测了一些人类写作的托福论文。红色条带是非英语母语作者写的论文,灰色条带是英语母语作者写的。

比如第一行Originality.ai,将76%的非英语母语作者写的论文判断为AI生成,将1%的英语母语作者的论文判断为AI生成。这个结果非常“伤人”——仅仅因为英语一般(非英语母语),写的东西就被认为不是人类写的!

语言匮乏将被“惩罚”!

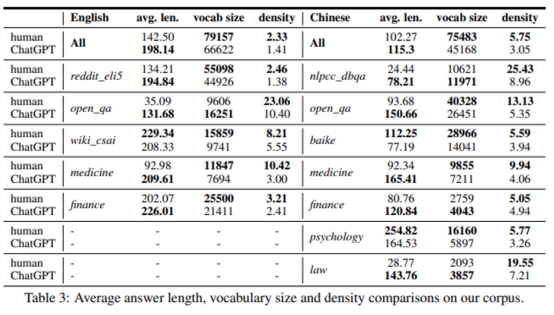

有一个来自我国的研究者的很有趣的研究,解释了一些为什么非英语母语的创作者会受到检测器的“歧视”![4]下面是作者给出的一张表格:

解释一下这张表。表格里统计了句子的平均长度、词汇量还有词语密度三个特征。表格体现的结果总结一下就是:人类的回答一般更短,但却说了更丰富的词汇。作者计算了收集到的所有的领域,发现人类的词汇密度都比ChatGPT高!不止是词汇密度,有很多研究分析了词汇丰富程度、词汇多样性、句法的复杂性、语法复杂性等多个方面,非英语母语的作者都显著地比英语母语作者差。

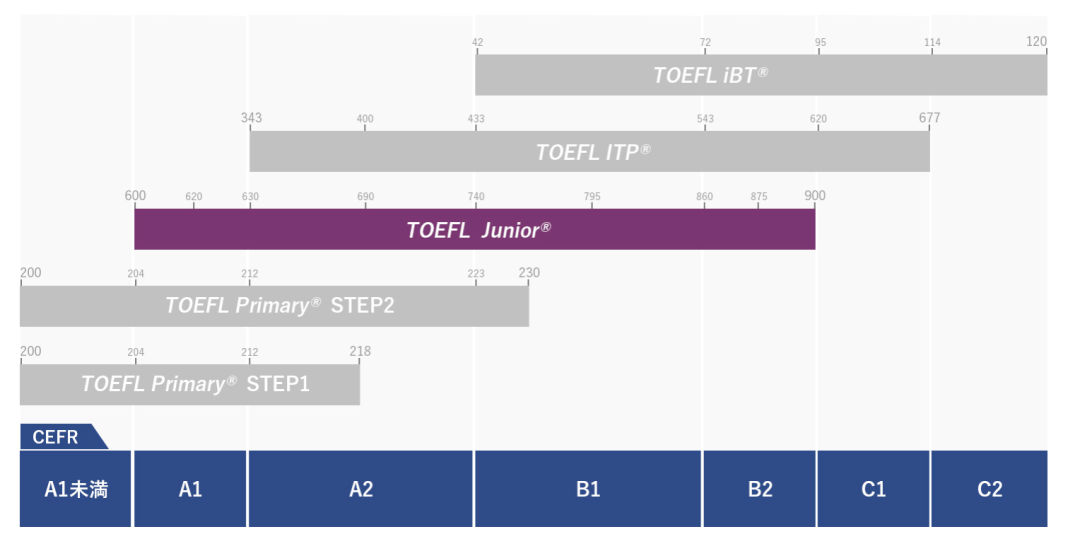

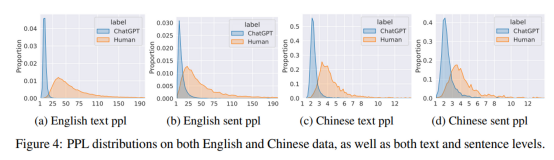

再看这个结果,使用人工智能生成的文本,困惑度(ppl)和人类写作的困惑度在统计学上很容易分辨。蓝色代表人工智能的作品,橙色是人类作品。作者分别选择了英文语料、中文语料,分别是文章和句子。

人工智能生成的文本,困惑度大多都非常低(横轴是困惑度),而人类作品的困惑度分部则呈现出很大的随机性。困惑度这个参数刚刚已经提过一下,困惑度可以用来衡量对常见语言模式、语句结构的符合程度。(困惑度越低,越符合常见的模式)这些结果其实一点也不意外,我们自己在写论文的时候也有感觉。

看英语母语作者的论文感觉词汇量和表达更加丰富,但是我们自己写的论文往往套路化、公式化的结构比较多。尽管这些公式化套路化的语言大多来自日常阅读论文的积累,但在GPT检测器面前,这仿佛就是“AI生成”的最好证据。

润色一下,结果也许会不一样

前面一些研究的结果虽然看起来很不乐观,非母语国家的创作者,在ChatGPT出现后反而成为了“被误伤”的主力军。不过,很多小伙伴一定想过了,如果我自己写一篇文章,然后使用ChatGPT来润色,结果是不是会好一些呢?

确实如大家所愿!

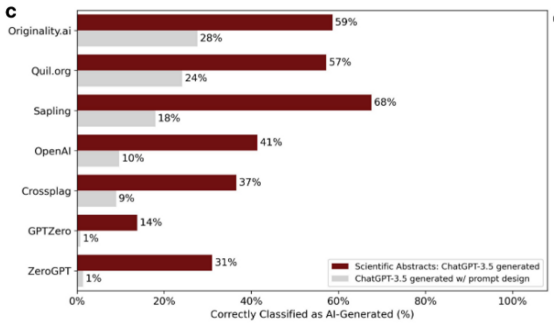

下面这幅图,仍然是检测器检测的结果,不过这些被检测的文本使用ChatGPT进行了一轮“润色”(使用提示词“Elevate the provided text by employing advanced technical language”)。

检测结果变好了很多,比如最顶端那一列,原始文本有接近60%的概率将AI生成的文本识别出来,而经过ChatGPT自我润色后,检测出来的概率只有28%。

当然,这个概率是否能达到大家的预期就见仁见智。不过,对于AI生成文本的检测从未停止,新的检测技术如雨后春笋快速出现,现有的GPT润色是否还能“欺骗”检测器?这恐怕是一个长期的拉锯战。所以,作为一个科研工作者,偷懒虽然是我们孜孜不倦努力的动力,但是有的时候,还是靠自己更踏实一些。

如果实在不愿意费力提升英文水平,那么找英文水平更高的人帮忙润色也不失为一个好的选择。

[1] GPTZero · Streamlit (etedward-gptzero-main-zqgfwb.streamlit.app)

[2] Gehrmann, Sebastian, Strobelt, Hendrik and Rush, Alexander M.. "GLTR: Statistical Detection and Visualization of Generated Text.."CoRR abs/1906.04043 (2019):

[3] Liang, Weixin, et al.GPT Detectors Are Biased against Non-Native English Writers. Apr. 2023.

[4] Guo, Biyang, et al.How Close Is ChatGPT to Human Experts? Comparison Corpus, Evaluation, and Detection. Jan. 2023.