竞赛总结:KDD2024 OAG-Challenge

比赛名称:KDD2024 OAG-Challenge

比赛类型:自然语言处理、大模型

比赛任务:学术数据挖掘

https://www.biendata.xyz/kdd2024/

赛题背景

学术数据挖掘(Academic Data Mining)是利用数据挖掘技术来分析和理解科学发展、本质和趋势的过程。

- 通过分析学术数据,政府可以更好地理解科学领域的发展趋势,从而制定更有效的科学政策。

- 企业可以通过分析学术数据来识别潜在的人才,这对于招聘和团队建设至关重要。

- 研究人员可以利用学术数据挖掘来更高效地获取新知识,加速科研进程。

尽管学术数据挖掘的潜力巨大,但社区在推进学术图挖掘(Academic Graph Mining)方面遇到了挑战,主要原因是缺乏合适的公共基准数据集。学术图挖掘是指在学术领域内,通过图结构来表示实体(如作者、论文、会议等)及其相互关系,并进行分析的过程。

为了解决这一问题,KDD Cup 2024(知识发现和数据挖掘大会杯,是一个国际知名的数据挖掘竞赛)提出了开放学术图挑战(Open Academic Graph Challenge,简称OAG-Challenge)。这个挑战包括三个现实且具有挑战性的数据集,旨在推动学术图挖掘技术的发展。

赛题任务

OAG-Challenge是一个专注于学术图挖掘的竞赛,它包含了三个任务,每个任务都旨在评估学术图挖掘的不同方面。

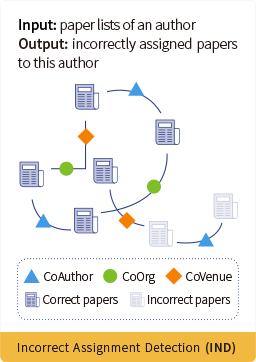

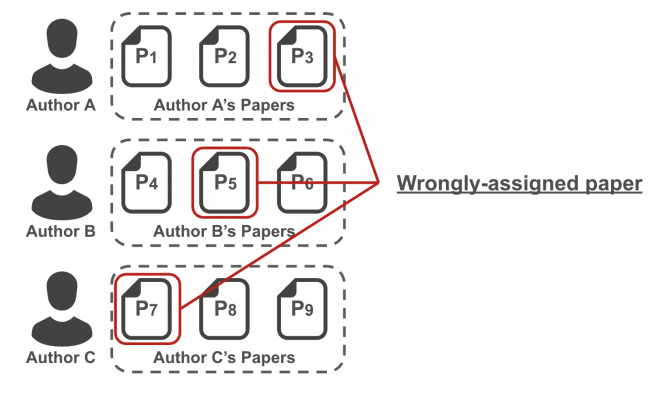

WhoIsWho-IND(作者名字消歧任务)

给定每位作者的个人资料,包括作者姓名和发表的论文,参赛者需要开发一个模型来检测论文中错误分配给该作者的论文。此外,数据集还提供了所有涉及论文的详细属性,包括标题、摘要、作者、关键词、地点和发表年份。

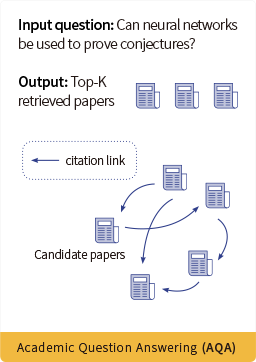

AQA(学术问题回答任务)

在本任务中,参与者的任务是使用问题-论文对来训练检索模型。该数据集来源于OAG-QA,OAG-QA从StackExchange和知乎网站检索问题帖,提取答案中提到的论文URL,并将其与OAG中的论文进行匹配。参与者将获得问题数据集,并需要找到与这些问题最匹配的论文。

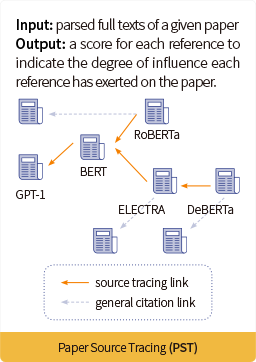

PST(论文来源追踪任务)

论文源头追溯任务的目的,是在给定一篇论文p的全文的情况下,从这篇论文中找出ref-source。ref-source即最重要的参考文献(叫做“源头论文”),一般是指对本篇论文启发性最大的文献。每篇论文可以有一篇或多篇ref-source,也有可能没有ref-source。对于论文的每一篇参考文献,论文源头溯源都要给出一个范围在[0, 1]的重要性分数。

评价指标

WhoIsWho-IND(作者名字消歧任务)

我们采用异常检测中广泛采用的 AUC作为评估指标。对于每个作者,

对于所有作者( 是作者数量),

AQA(学术问题回答任务)

我们利用平均精度 (MAP) 和 top-k MAP 作为评估指标。

对于每个问题 , 平均精度(AP)将根据以下公式计算:

其中 是标记为正例的论文 ID 的数量, 表示数据库中论文的数量, 是问题 的排名列表中截止第 个的精度。 是一个指示函数;如果第 个返回的论文偏好符合标准答案, ,否则 。

对于给定的 个问题,我们将用以下方式计算MAP:

PST(论文来源追踪任务)

我们将计算结果的 (平均精度均值)进行打分和排名。对于测试集中的每篇论文会先计算 (平均精度), 的计算公式如下:

其中 是正例(重要参考文献)的数目, 是对排名列表中截止第 个的精度, 是真实的标注结果,取值为 0 或 。 0 为负例,非重要参考文献, 1 为正例,重要参考文献。 表示该论文的参考文献数目。然后计算所有论文的 的均值,得到 :

优胜方案(IND赛题)

NJUST

https://openreview.net/attachment?id=1mYLGW4OqL&name=pdf

方法概述

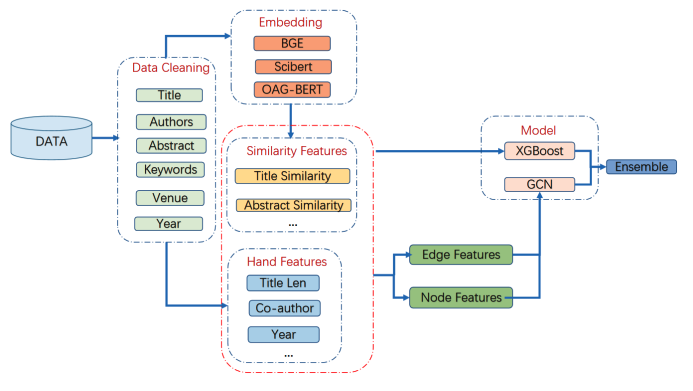

- XGBoost:使用梯度提升的高效可扩展实现,用于分类任务。

- 数据清洗:移除缺失值和重复项,规范化文本字段。

- 嵌入:使用BGE、SciBERT和OAGBERT模型生成论文的嵌入向量。

- 特征工程:提取包括共同作者权重、标题相似度等特征。

- 图卷积神经网络(GCN):

- 特征提取:从每篇出版物中提取标题、摘要、关键词等属性,并使用嵌入模型转换为数值表示。

- 图构建:构建一个图,其中每个节点代表一篇论文,边表示论文之间的相似性。

- GCN应用:应用GCN来模拟论文之间的关系,通过迭代图卷积层学习模式和特征。

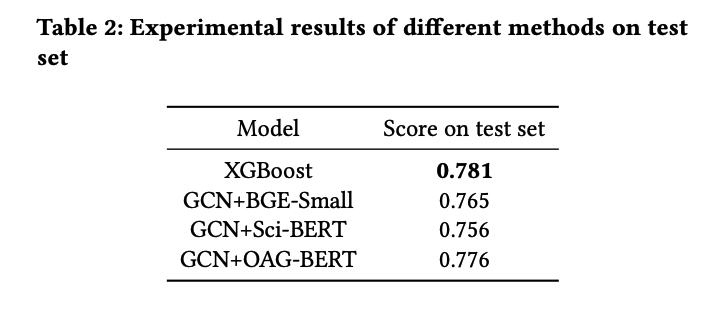

实验结果

- XGBoost实验:通过大量实验设置训练参数,使用10折交叉验证和早停策略来训练模型。

- GCN实验:评估了BGE-Small、Sci-BERT和OAG-BERT三种不同的嵌入模型,通过提取每个节点的特征来构建图。

- 集成:将不同解决方案的结果集成,集成模型达到了最高的准确性0.801。

SEU & SHNU

https://openreview.net/attachment?id=EemsomTRmv&name=pdf

方法概述

- 假设:对于每位作者,分配给他们的大多数论文构成了他们的相关论文集。因此,将比赛视为一个异常检测问题,确定每篇分配给作者的论文是否属于主要论文集群。

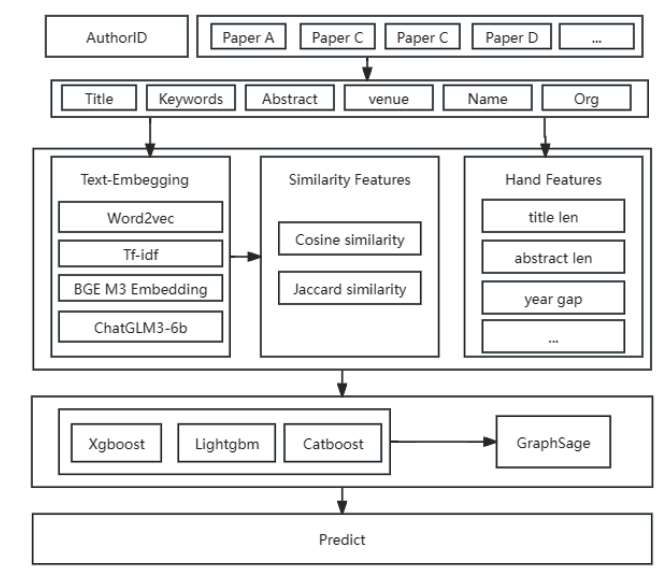

- 架构:模型的总体架构分为三部分:文本嵌入方法提取论文的语义表示、特征工程工作、以及决策树模型和基于图神经网络的模型。

- 使用多种词向量方法(TF-IDF、Word2vec、BGE-M3-Embedding、ChatGLM3)来提取论文的语义表示。计算论文之间的余弦距离和Jaccard相似度,并将这些与手动特征结合作为模型输入。

- 使用LightGBM、XGBoost、CatBoost等决策树模型,以及GraphSAGE等基于图神经网络的模型。GraphSAGE通过聚合邻居信息来学习节点表示,构建同质图结构,并通过聚合信息来探索论文之间的潜在关系。

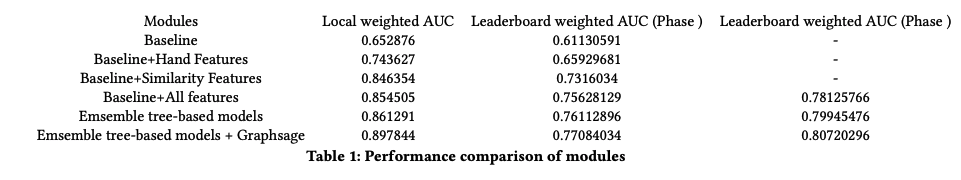

实验结果

通过作者ID对数据进行分区,并进行交叉验证。比较不同模块在三个数据集上的性能,展示了多种文本嵌入提取方法的互补性,以及建立不同节点关系的重要性。

Fraunhofer FIT

https://openreview.net/attachment?id=itaOsr82J4&name=pdf

- 数据来源:使用的数据来自AMiner.cn提供的WhoIsWho数据集。

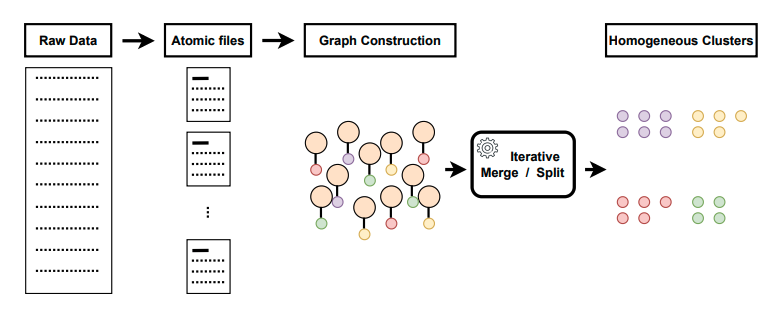

- 图结构构建:将数据转换为图结构,其中节点代表各种特征,并通过迭代合并或分裂这些节点组,直到生成同质论文的聚类。

- AND-MCMC算法:该算法用于检测每个作者文件中错误分配的论文。关键步骤包括:

- 数据加载和转换:加载作者数据,并将其转换为原子名称文件格式,便于后续图构建和操作。

- 图构建和论文抽样:创建一个图结构,所有论文节点最初都连接到代表作者的单个原子节点。从这个图结构中,随机选择一个论文节点进行潜在的合并或分裂操作。

- 动作选择和优先级:算法选择对抽样论文节点执行的动作,可以是合并或分裂操作。在迭代过程中,优先考虑分裂操作以分离错误分配的论文。

- 动作执行和迭代细化:对抽样论文节点应用选定的合并或分裂动作,要么将其与现有图结构合并,要么创建一个新的图结构。这个过程重复进行,直到达到稳定的图拓扑结构,逐步细化图结构,并将错误分配的论文从主要作者的作品中分离出来。

- 异常识别:收敛后,具有最多论文节点的图结构被认为是代表正确作者的论文。相反,剩余的图结构被标记为异常或错误分配的论文。

DIEq

https://openreview.net/attachment?id=IZ9GIjBKp8&name=pdf

方案概述

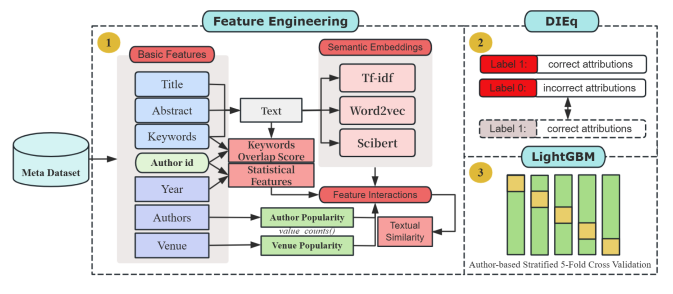

DIEq通过将一部分负样本同时视为负样本和正样本,创建“学术身份幻影”。这种方法利用了数据不平衡,同时丰富了特征空间,迫使模型学习更细微和区分性的作者身份表示。

研究者精心设计了超过3000个特征,包括文本、语义和作者特定的统计属性。对于每个作者,计算所有文本中前100个最频繁的词汇,并为每个样本计算样本文本与作者关键词集的重叠分数。

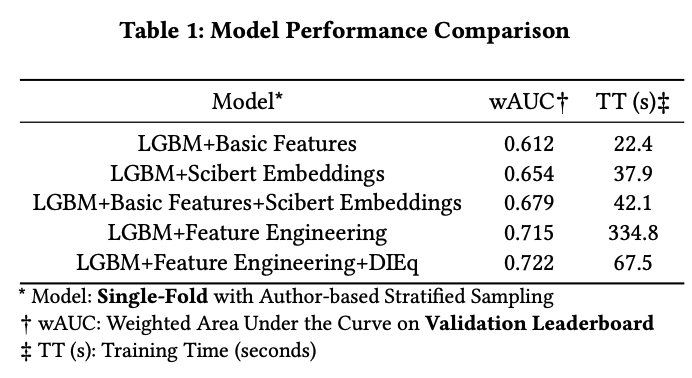

实验结果

计算代表作者所有文章的平均嵌入和当前样本文章嵌入之间的余弦相似度。在KDD Cup 2024的WhoIsWho-IND任务中,DIEq方法在测试数据上实现了wAUC的显著提高,并加快了训练收敛速度。

Z Lab

https://openreview.net/attachment?id=fAWMv3V4dn&name=pdf

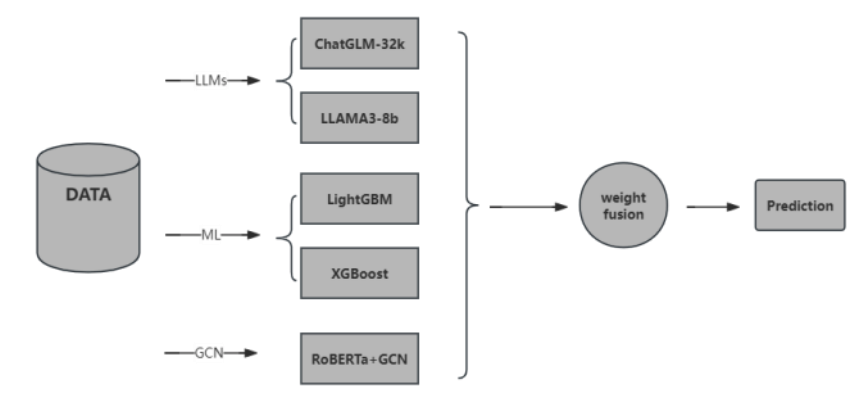

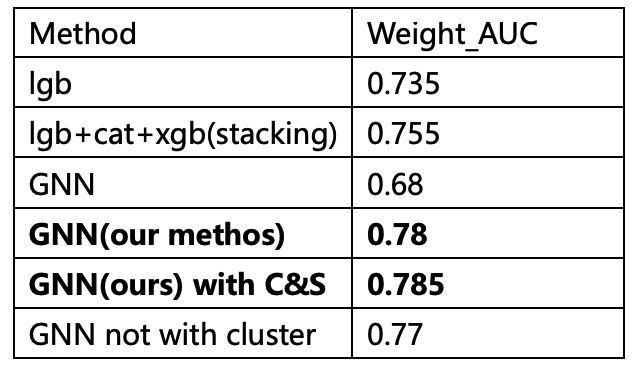

方案概述

- 图卷积网络模型(GCN):用于处理图结构数据,捕捉作者-论文网络中的复杂关系和结构信息。

- 梯度提升决策树:使用XGBoost和LightGBM模型,这些是基于决策树的集成学习框架,通过强大的特征工程带来很好的结果。

- ChatGLM-32K:用于处理长文本并生成额外的语义特征。

- LLaMA模型:用于增强特征表示并执行少量样本学习。

实验结果

- 将GCN学习到的节点表示、RoBERTa生成的标题编码和手工制作的特征结合起来,形成全面的特征集。

- 使用加权平均方法融合GCN、LightGBM和XGBoost的预测结果。

East China Normal University & ICT

方案概述

- 文本处理:创建了包括标题、关键词、摘要等的文本表示,并将其转换为数值嵌入。

- 统计特征:基于作者的出版历史聚合统计数据,计算了各种文本字段的长度,并得出统计度量。

- 作者特定特征:识别作者频繁合作的顶级作者和组织。

- 数据合并与集成:将处理过的特征与原始数据集合并,创建用于训练和验证的全面特征集。

- 基于特征重要性选择了前500个最重要的特征,并使用LGBMClassifier进行训练。

- 通过指令调整,提高了预训练模型对特定任务的性能,使其更准确地遵循人类指令。

- 针对WhoIsWho-IND任务,使用大型模型来确定特定文本(目标论文)是否属于给定的作者文本集合(论文集合)。

实验结果

- 将LightGBM模型和LLM模型的概率进行归一化和加权求和,以提高分数。

- 特征重要性分析表明,文本相似性特征在准确识别作者ID和论文之间的文本上下文和相似性方面起着主导作用。

CQUPT

https://openreview.net/attachment?id=mWTicE6SZS&name=pdf

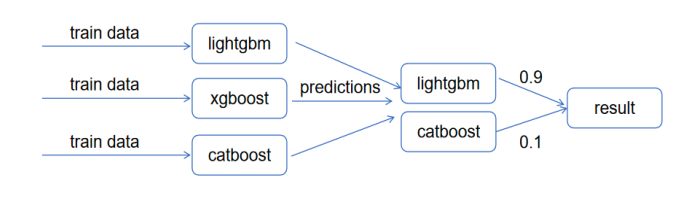

方案概述

- 多尺度和聚类特性的图神经网络:提出了一种利用多尺度和聚类特性的图神经网络来提取和拼接不同的特征,这些特征通过聚类层处理后进行分类。

- 数据清洗和特征工程:在数据预处理阶段,将中文作者名字转换为拼音,统一小写,去除噪声和停用词。在特征工程方面,构建了统计特征、交叉特征、年份相关特征和相关组织特征,并使用Word2Vec模型对每篇论文进行了词嵌入。

- 树模型训练:主要使用GBDT模型,通过迭代减少训练残差来提高分类或回归任务的准确性。

- 基于图的作者消歧:使用图卷积神经网络(GCNs)来处理作者名字消歧任务,通过图结构和节点特征向量的结合来更新节点的特征向量。

- 建立基于论文关系的论文图数据:定义了四种论文之间的关系类型:共同作者、共同组织、共同关键词和共同发表场所。

实验结果

使用AUC作为评估指标,实验结果表明,设计的网络效果优于普通模型,并且比具有大量手动设计特征的模型效果更好。

NTT DOCOMO, INC.

https://openreview.net/attachment?id=REiYBHNS1m&name=pdf

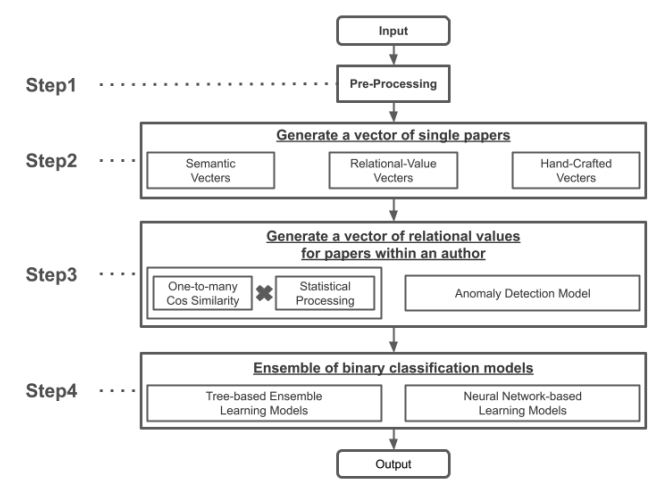

方案概述

- 数据清洗:对自然语言数据、作者名字信息和论文发表年份的数值信息进行清洗。

- 生成论文嵌入:结合手工创建的向量、语义向量和关系值向量来获得论文嵌入。

- 生成每名作者论文间的关系值:计算每名作者关联的论文之间的关系值,使用余弦相似度、聚类和异常检测模型。

- 使用二元分类模型检测错误:结合多种算法构建二元分类模型,预测每篇论文是否为分配错误。

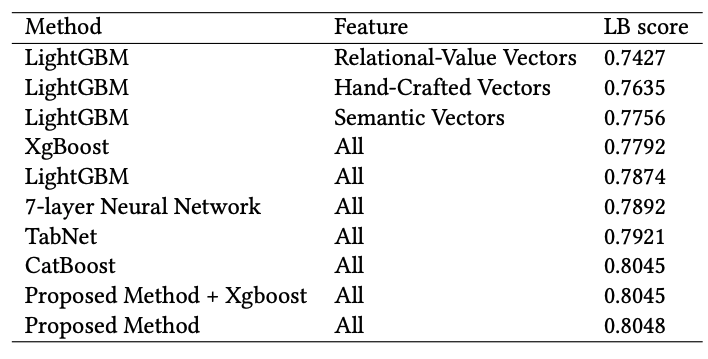

实验结果

配备NVIDIA A10G Tensor Core GPU和32GB内存的Amazon EC2实例上进行实验。

通过不同的模型组合,最终在公共排行榜上获得了0.80487的得分,排名第6。

Xiangyuxing Investment

https://openreview.net/attachment?id=oxOEqVH4tI&name=pdf

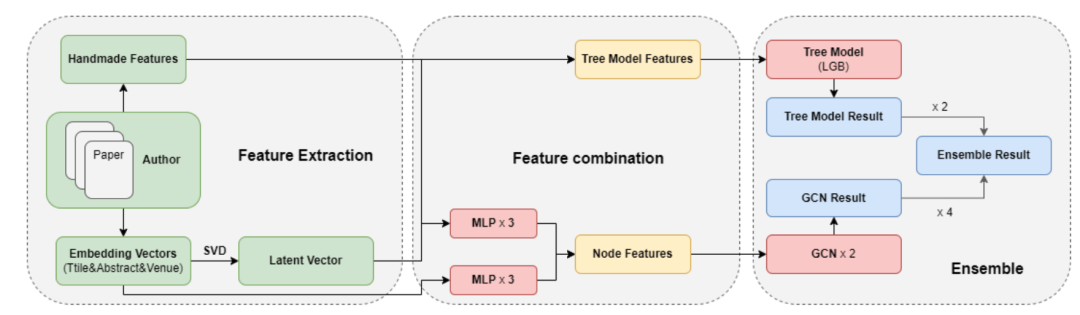

方案概述

- 在特征提取阶段,从不同角度提取了多种特征。

- 在特征组合阶段,将不同的特征整合输入到不同的模型中。

- 在模型集成阶段,基于不同特征训练多个模型,并通过分配不同权重将这些模型集成。

- 构建图,每个作者作为一个图,论文为节点,同一作者的论文之间的连接为边。

实验结果

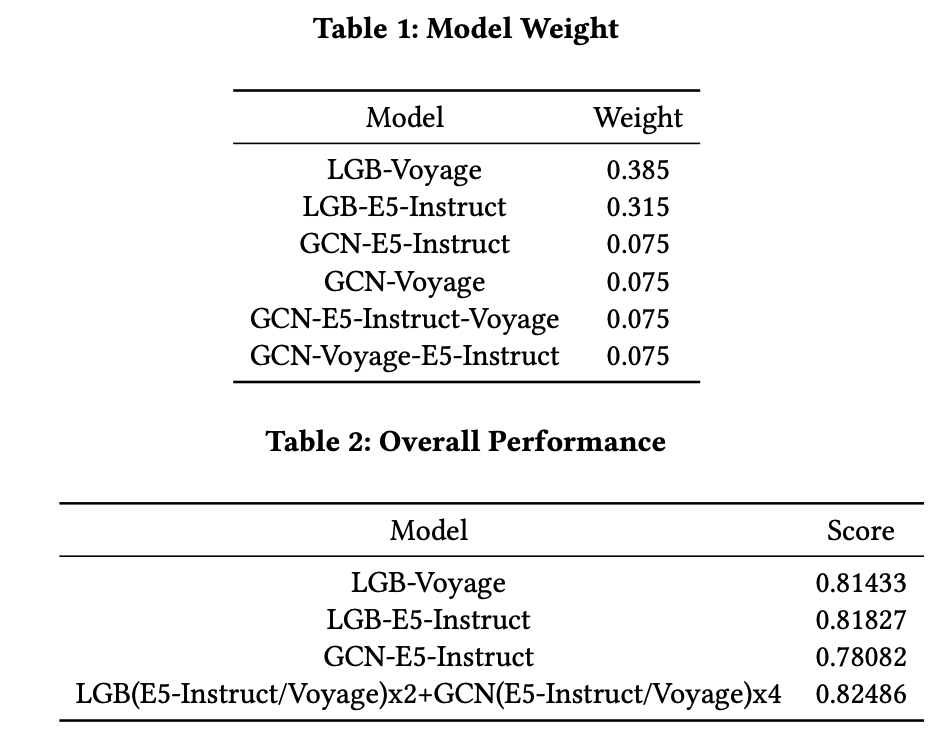

模型性能如表2所示,树模型优于图神经网络,E5-Instruct模型比Voyage模型在描述论文上更有效。

虽然单独的图神经网络效果不佳,但与树模型集成是有益的。

MeiTuan

https://openreview.net/attachment?id=KvxDiwWe9E&name=pdf

方案概述

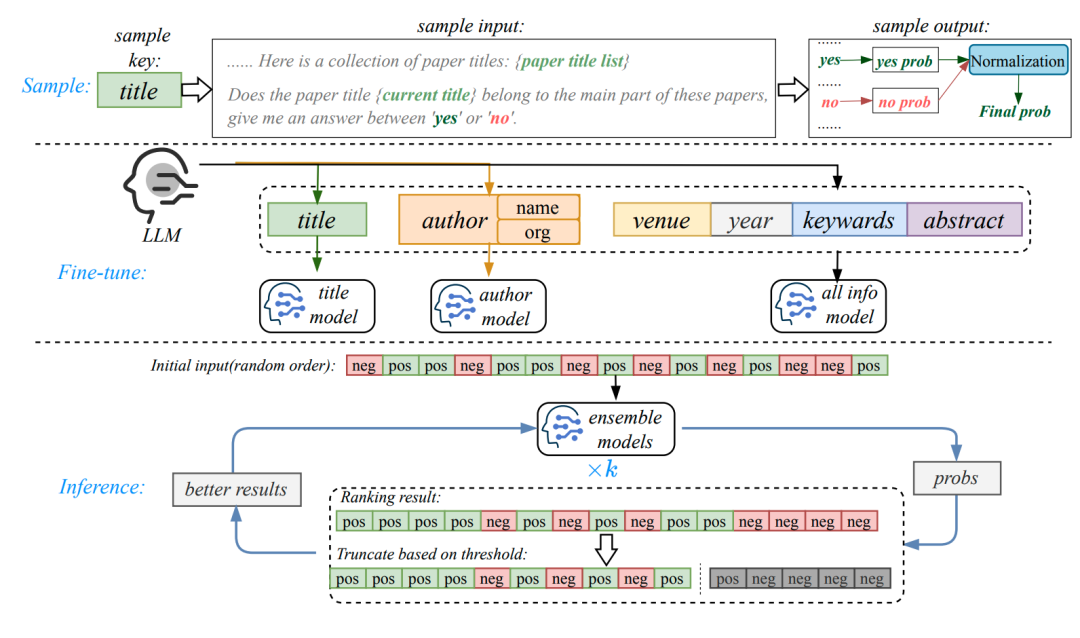

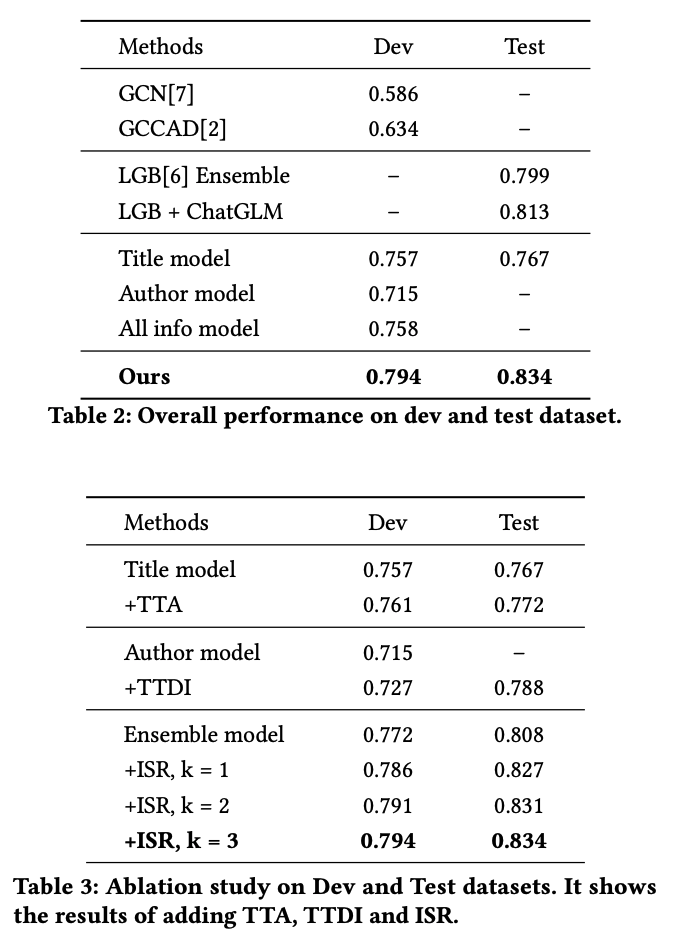

图2显示了我们的框架。在微调阶段,多个模型针对不同的信息源进行微调。在推理阶段,使用迭代自精炼方法重新整合模型的输出作为下一轮的输入,从而增加识别正确论文的概率。

我们继续使用基线的微调方法,将聚类任务转化为比较任务,输入一组参考论文,并判断当前论文是否为主类别。经验上,输入中的参考论文越多,当前判断结果的可信度越高。但是,在最大输入长度的限制下,输入中拼接的参考论文越多,每篇论文包含的信息就越少。

为了解决这个问题,我们开发了一种策略,将多个信息源分割、微调和最终整合。基于逻辑推理和实验验证,我们确定了标题和作者作为微调模型的两个最关键的信息源,使用Low-Rank Adaptation (LoRA)作为微调技术。

由于我们使用比较任务来确定当前论文是否属于主类别,推理阶段可以扩展推理长度以包含更多的参考论文,从而增强模型的推理能力。很自然地,参考论文中正确论文的比例越高,模型对当前论文正确性的判断就越有信心。

实验结果

我们的实现基于Pytorch。选择的基础模型是ChatGLM-6B-32k。训练周期数设置为1。

总体性能如表2所示。根据实验结果,可以得出结论,图神经网络方法在比赛数据集上表现不佳,表明有很大的改进空间。基于树的模型取得了值得称赞的性能,在测试数据集上的得分为0.799。将大型模型输出的特征与基于树的模型相结合,取得了更好的结果,在测试数据集上的得分为0.813。

优胜方案(AQA赛题)

NJUST

https://openreview.net/attachment?id=sBxql6bzym&name=pdf

方案概述

- 问题简化:使用LLMs简化复杂学术查询,提高后续论文检索的准确性。

- 高效向量检索和重排序:采用FAISS进行向量检索,并通过重排序模型细化结果,确保高精确度。

- BGE模型调优和融合:选择BGE模型生成高质量文本嵌入,并通过硬样本挖掘进行微调,提高模型的鲁棒性和准确性。

- 论文嵌入:使用增强的BGE模型为所有论文生成嵌入,并存储在FAISS向量数据库中。

- 问题简化和嵌入:使用LLM简化问题,然后使用BGE模型进行嵌入,确保查询与论文的匹配。

- 检索和重排序:使用FAISS进行初步检索,然后应用BGE-Reranker-v2-minicpm-layerwise模型进行重排序。

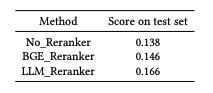

实验结果

通过实验评估了重排序模型对检索性能的影响,比较了不使用重排序、使用bge_reranker模型和使用bge-reranker-v2-minicpm-layerwise模型三种配置的性能。

MOE KLINNS Lab & XJTU & Bytedance

https://openreview.net/attachment?id=bVqeenaDoz&name=pdf

方案概述

- 任务目标:训练一个检索器,能够精确检索与专业学术问题最相关的论文。

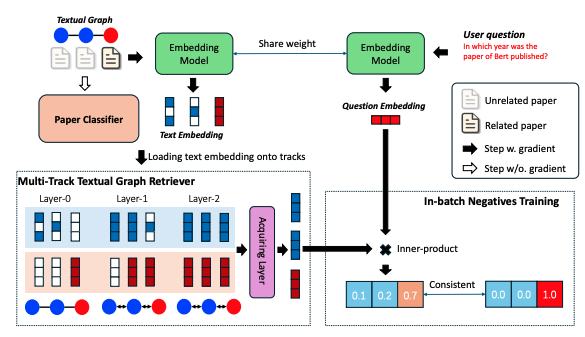

- 系统设计:设计了三个主要模块:论文分类器、多轨文本图检索器和检索任务训练。

论文分类器

- 基于上下文学习:使用提示(prompts)进行上下文学习,以少量标注示例对文档进行分类。

- 提示组成:任务描述、示例数据、测试输入。

- 期刊-论文映射:通过期刊推断论文的具体类别,减少了推理次数。

多轨文本图检索器

- 构建文本属性图:基于官方提供的额外数据集,构建包含引用关系的文本属性图。

- 多轨消息传递机制:避免GNN中的过平滑和过压缩问题,使GNN能够嵌入更丰富的结构信息。

- 消息传递步骤

- 加载:将节点的初始特征加载到对应的轨道上。

- 多轨消息传递(MTMP):在各自的轨道上进行消息传播和聚合。

- 获取:从最终消息中获取论文节点的最终表示。

- 检索任务训练:使用InfoNCE损失训练,以区分相关和不相关的文本对。

实验结果

基于硬负例挖掘,动态更新训练集,确保模型在训练过程中尽可能长时间地沿正确方向更新梯度。

使用OAG-QA数据集,包含问题-论文对。提供了一些在验证数据集中检索到的查询结果,显示了方法的有效性。

Robo Space & Ant Group

https://openreview.net/attachment?id=3OA5hMTidj&name=pdf

方案概述

方案由三个主要部分组成:

- 预训练模型的嵌入提取

- 预训练模型的监督微调

- 预训练模型的相似性融合

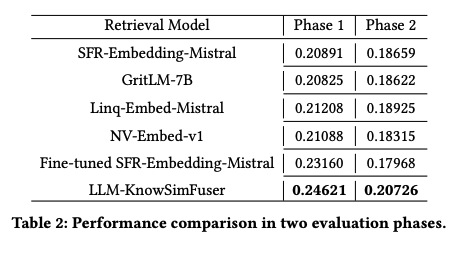

使用四种不同的LLM增强型预训练模型来分别提取查询和文档的嵌入,SFR-Embedding-Mistral模型因其简单性和灵活性而被选为微调的最佳候选模型,使用Faiss库计算查询和文档之间的相似性矩阵,并进行归一化处理,以确保不同模型的分数在同一尺度上。

实验结果

- 实验在配备有特定硬件的机器上进行,包括CPU、RAM和NVIDIA RTX A6000 GPU。

- 使用LoRA对SFR-Embedding-Mistral模型进行微调,并在GitHub上公开源代码,以促进可重复性。

- 分析了不同检索模型和融合模型在两个评估阶段的性能,并展示了LLM-KnowSimFuser在两个阶段中得分最高,表现出色。

UCAS & BJUT

https://openreview.net/attachment?id=O2sbpxmMOh&name=pdf

方案概述

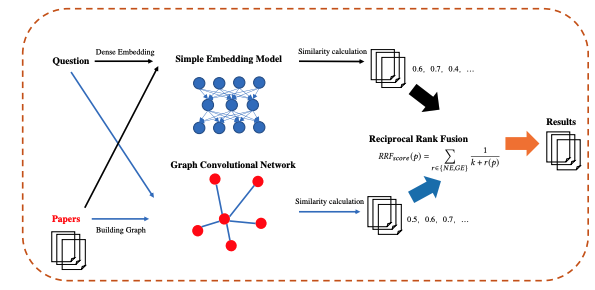

- 使用密集编码器将每篇论文映射到一个实值向量,并为所有论文构建索引。

- 将输入问题映射到一个向量,并检索与问题向量最接近的论文。

- 通过优化损失函数,使得点积相似性成为一个好的排名函数,从而创建一个向量空间,使得相关的问题和论文对具有较小的距离(即更高的相似性)。

- 简单嵌入检索器只考虑用户问题和论文之间的语义相似性,但忽略了论文之间的关系(例如引用)。

- 引入基于图卷积网络(GCN)的检索器,该检索器结合了论文之间的关系结构。

- 从简单嵌入检索器和图嵌入检索器中选择与用户问题最相似的100篇论文。

- 使用互惠排名融合(RRF)来集成检索结果,选择具有最大RRF分数的20篇论文作为最终检索结果。

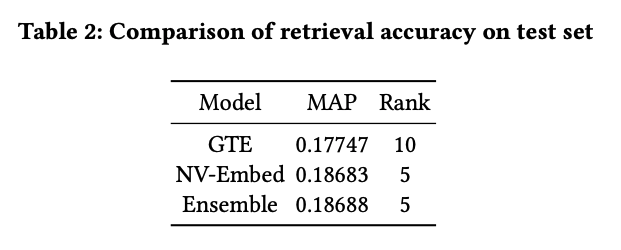

实验结果

- 使用OAG-QA数据集验证所提出方法的有效性,该数据集聚合了来自StackExchange和Zhihu等学术问答平台的问题-论文对。

- 实验设置包括预训练模型NV-Embed和GTE作为密集编码器,以及训练参数。

- 使用平均精度(MAP)和top-k MAP作为评估指标,并对不同模型在测试集上的检索精度进行比较。

Sun Yat-sen University

https://openreview.net/attachment?id=oRz2IoEJEY&name=pdf

方案概述

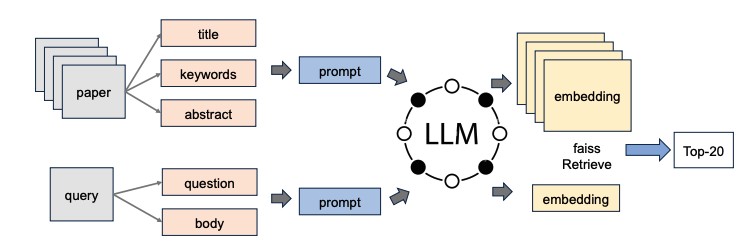

- 整体框架:如图1所示,设计提示(prompts)用于LLMs处理查询和论文,然后分别为它们生成嵌入。使用Faiss库进行检索,以找到与查询最匹配的前20篇论文。

- 提示设计:将输入查询与查询模板结合,形成输出提示。对于论文的提示,将标题、摘要和关键词文本进行拼接。

- 嵌入生成模型:使用Nv-Embed作为预训练的LLM模型进行推理,可以从Hugging Face访问。NV-Embed展示了新设计,包括让LLM关注潜在向量以获得更好的聚合嵌入输出,并展示了两阶段指令调整方法以提高检索和非检索任务的准确性。

- 检索:使用Faiss作为后端进行相似性评分和语义搜索。Faiss在学术界和工业界广泛用于最近邻搜索、聚类和降维任务。

实验结果

使用PyTorch和Transformers库实现,利用预训练的Nv-Embed模型。设置批量大小为2,最大序列长度为4096个token,有效管理内存消耗。

尽管解决方案不涉及微调步骤,但在公共和私人排行榜上均获得了前9名的成绩。

MeiTuan

https://openreview.net/attachment?id=vhLAb1dpIw&name=pdf

方案概述

- LLM for Vector:在文本表示的初始阶段,通常依赖于自编码器模型来衡量相似性,但这些模型在这项任务中表现不佳。相比之下,近年来从大型语言模型(LLMs)派生的向量表示在性能上表现出色,并且在这项特定任务中也表现出色。

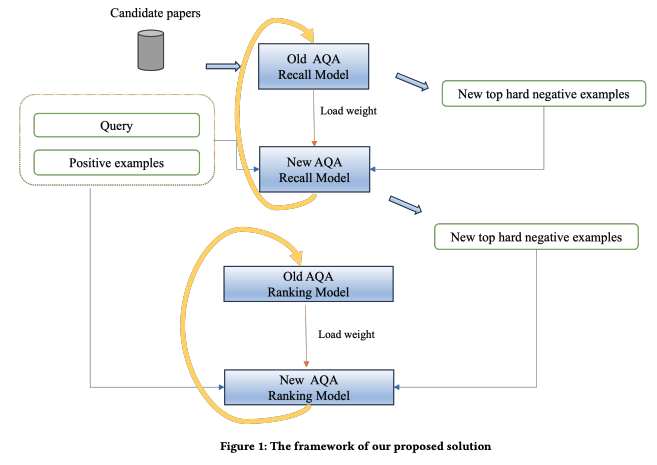

- 迭代硬例挖掘与提升:在“相似性不一定意味着正确性”的背景下,识别负面样本挖掘的关键作用。挖掘硬例的过程对于有效的模型学习至关重要,因此引入了“迭代硬例挖掘与提升”策略。这种方法逐步召回更具挑战性的负面样本,最终整合它们以提高整体性能。

实验结果

通过实施迭代硬负面样本挖掘与提升策略,模型的MAP@20分数随着每次迭代逐步提高。在第六次迭代后,改进速率开始放缓。最终进行了八次迭代,并应用排名平均(Rank avg)到最终分数,得出MAP@20为0.301。

NTT DOCOMO, INC.

https://openreview.net/attachment?id=HyvHFtoSox&name=pdf

方案概述

任务定义:开发一个模型,针对各种领域的问题检索最相关的论文。

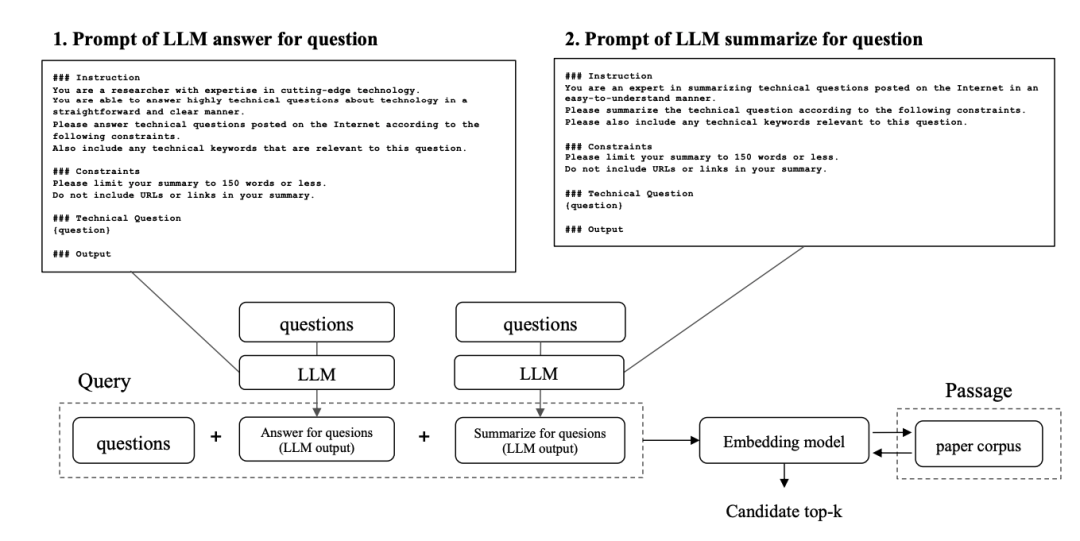

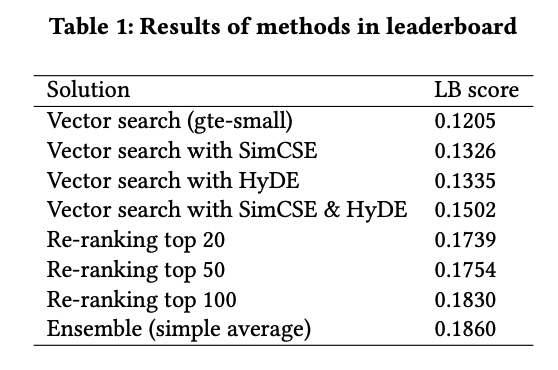

方法概述:两阶段预测模型,第一阶段使用对比学习和LLM增强的查询生成候选论文,第二阶段使用编码器模型重新排名这些候选论文。

- 第一阶段:使用SimCSE进行对比学习和使用HyDE生成查询增强。

- 第二阶段:使用编码器模型进行二分类和重新排名,最终通过集成多个模型的预测来获得最终分数。

实验结果

OAG-AQA比赛数据集由StackExchange和Zhihu网站的问题提交生成,包含466,387篇论文记录和8,757条训练数据记录。

通过增加候选论文的数量和使用不同的负样本下采样率,模型在公共排行榜上的得分得到提高。

Onewo Space-Tech Service Co., Ltd.

https://openreview.net/attachment?id=7BEsjZ62q0&name=pdf

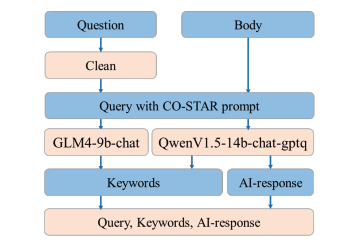

方案概述

该团队开发了一种创新方法,包括四个阶段:数据处理和增强、候选生成、候选排名和加权集成。

特别强调数据增强,其中LLMs模型被用来改进查询和正文文本,包括生成关键词和基于有效提示模板的AI响应。

实验结果

通过测试基准,团队实现了性能指标的显著提升,得分从0.16526提高到0.18367。Onewo团队在AQA-KDD-2024竞赛的最终排行榜上获得了第8名。

Xiaohongshu Inc.

https://openreview.net/attachment?id=iH203OQIU5&name=pdf

方案概述

- 使用预训练语言模型(PLMs)构建双编码器(bi-encoder)框架,生成问题和正文的嵌入(表示为Q),以及论文标题和摘要的嵌入(表示为D_i)。

- 探索了两种重排方法:构建交叉编码器模型和训练多个双编码器模型并集成预测结果。

实验结果

使用不同的PLMs进行双编码器实验,并使用bge-reranker-large进行交叉编码器实验。

优胜方案(PST赛题)

Ant Group & Alibaba Group & Cardinal Operations

https://openreview.net/attachment?id=H5wbKuYjxr&name=pdf

方案概述

- 使用闭源LLMs:由于没有GPU资源,该方案使用闭源LLMs直接从提供的论文中生成预测的参考文献来源,并通过集成学习来优化这些预测。

- 特征工程:虽然主要依赖LLMs进行文本理解和问题解决,但通过精心设计的特征来增强性能。这些特征包括论文的元数据、引用统计、参考文献的元数据和上下文关键词。

- LLM生成的答案:使用了四种最先进的LLMs:GPT-4 Turbo、GPT-4o、Gemini 1.5 Pro和Claude 3 Opus。这些LLMs被选中是因为它们在学术环境中的逻辑推理能力较强。

- 提示工程:设计了一系列提示,以从LLMs中引出细致的回答。这些提示包括基础提示、灵感聚焦提示、标题增强提示、元优化提示和基于注释的提示。

- 基础模型:除了LLMs生成的概率外,还使用了两种梯度提升框架:LightGBM和CatBoost。这些模型基于第3.1节中描述的特征进行操作。

- 集成方法:最终的预测模型结合了LLMs生成的答案和传统机器学习分类器的优势。对于每篇论文-引用对,目标是找到一个函数,将不同方法的预测结果结合起来。

实验结果

- 输入和输出:算法输入论文的主要文本和其引用列表,输出每个引用作为论文来源引用的概率。

- 基础得分:使用在训练集上训练的LightGBM和CatBoost模型,为每个引用打分,代表其成为来源引用的概率。

- LLMs结果的修改:基于LLMs的结果修改基础得分。这包括将LLM输出分组,并根据专家知识为每个组分配权重,然后将所有LLM组的结果根据其权重聚合以获得加分。

- 最终预测:最终预测是基础得分和LLM预测结果的加权组合。

Algorithm Engineer,Tgnet

https://openreview.net/attachment?id=nvt4nv42sJ&name=pdf

方案概述

- 将论文的标题、引用文献数量和相关上下文信息整合到一个独特的数据结构中,格式为“Title [SEP] Citation Number [SEP] Context”,以捕捉论文的基本和上下文信息。

- 在模型训练中,为了平衡正负样本比例,采用了1:4的比例构建样本,即每有一个正样本(具有明确引用或启发关系的论文对),生成四个负样本(没有这种关系的论文对)。

- 使用专门为计算机科学领域设计的预训练BERT模型SciBERTa-cs,并采用五折交叉验证进行微调,以确保模型在不同数据集上具有高泛化能力。

- 模型输出通过sigmoid函数转换为每个样本的预测概率,取这些概率的平均值作为最终预测结果,以减少单一预测的随机性并提高预测的稳定性和可靠性。

实验结果

- 初始阶段使用DeBERTa-base模型作为基线模型,通过1:4比例筛选正负样本进行二元分类,初步比赛中模型得分为36.48%。

- 替换基线模型为SciDeBERTa-CS并进行微调,同时将激活函数从默认的ReLU更改为Sigmoid,模型得分提高至40.00%。

- 引入特定的后处理策略,进一步优化模型的预测准确性,得分提升至46.20%

- 增强模型处理上下文信息的能力,使用五折交叉验证方法,最终模型得分提高至50.427%

Chongqing University & Southwest University & Chongqing University of Posts and Telecommunications

https://openreview.net/attachment?id=yDE86rqrjo&name=pdf

方案概述

- 数据构建:提取参考文献片段和标题。每个参考文献都在论文中被引用,因此可以定位到论文中的引用片段,并使用固定长度的窗口(200个字符)进行截断。考虑到源论文数量相对较少,通过随机收集样本来管理正负样本的比例,确保正负样本比例为1:10,不重复。

- 模型与改进:选择BERT作为分类模型,并使用SciBERT提供预训练权重。输入引用片段文本和被引用文献的标题到分类模型中,以实现特征交互并判断是否为源论文。

- 参数优化:通过调整学习率、批量大小、训练周期、预热比例和梯度裁剪,模型可以更好地学习数据中的重要特征以识别源论文。

- 模型融合:将训练数据集随机分成十部分并训练十个模型,选择在测试数据集上得分最高的三个模型进行模型融合,以增强模型性能。

实验结果

- 实验设置:在NVIDIA RTX4090 GPU上进行。

- 主要结果:模型融合后,测试数据集A的得分从0.454提高到0.465,测试数据集B的得分从0.434提高到0.449,与基于机器学习的特征工程方法相比有显著提高。

- 消融研究:在测试数据集A上,基线得分为0.283,参数优化后提高到0.414,数据重构后提高4%,模型融合后提高1.1%。

China University of Petroleum

https://openreview.net/attachment?id=9GsyxtumgI&name=pdf

方案概述

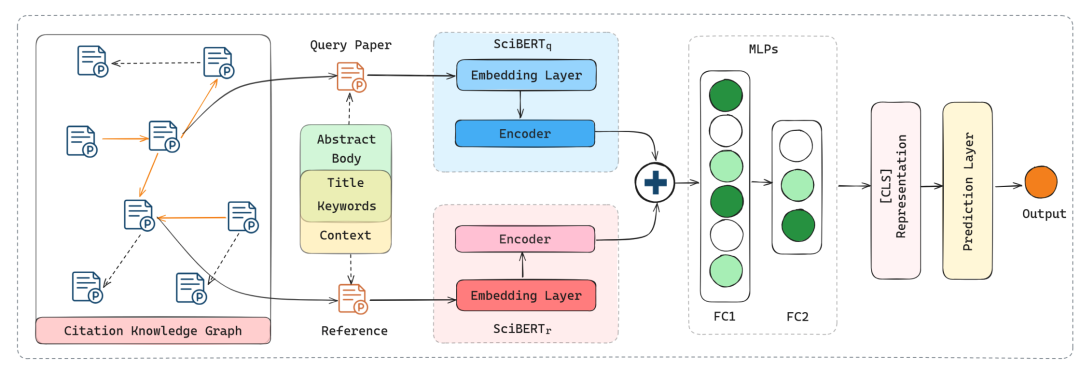

- 模型架构:使用神经协同过滤(NCF)模型,该模型在两个通道中分别处理论文和参考文献的特征,然后计算它们的相互相似度作为预测输出。

- 文本属性处理:利用预训练的语言模型SciBERT处理论文和参考文献的文本属性。SciBERT包含12个BERT层,每个层都实现注意力和前馈网络(FFN)机制。

实验结果

- 数据集:使用组织者提供的PST数据集,包括论文的标题、摘要、关键词和正文的前500个字符作为文本输入。

- 实验结果:模型在Mean Average Precision (MAP)指标上取得了0.37814的得分,超过了基线模型,并在所有参赛队伍中排名第11。

Toyota Motor Corporation

https://openreview.net/attachment?id=Mi5T2wgySR&name=pdf

方案概述

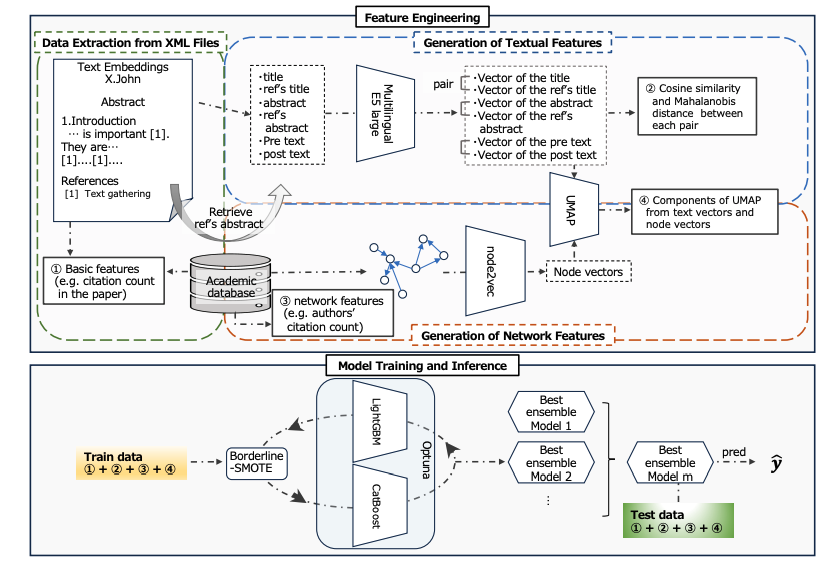

- 提取了论文ID、标题、作者和摘要,以及参考文献的标题、作者、引用位置和引用次数等信息。

- 使用多语言E5文本嵌入模型将文本嵌入到向量空间中,计算目标论文和重要论文之间的相似度,并使用UMAP进行降维。

- 基于引用关系构建学术数据库的网络,并使用node2vec生成节点嵌入,以量化每个节点的影响力。

- 使用生成的特征进行监督二元分类,训练了LightGBM和CatBoost模型,并使用Optuna进行超参数调优。

实验结果

- 模型在验证集和测试集上进行预测,最终在MAP评估中获得了0.44278的分数。

- SHAP值分析了模型对特征的重要性,发现“引用次数”是最重要的特征。

Shenzhen University & Onewo Space-Tech Service Co., Ltd.

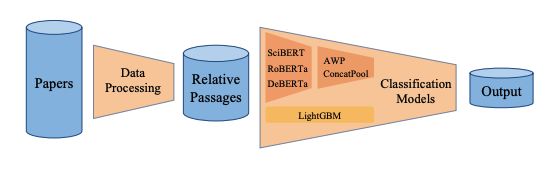

https://openreview.net/attachment?id=Q13sokYUHo&name=pdf

方案概述

- 对抗性权重扰动(AWP):在训练期间引入小的权重扰动以增强模型的鲁棒性和泛化能力。

- 拼接均值池化(ConcatPool):结合不同池化技术以捕获文本的局部和全局特征。

- 加权集成:通过不同权重整合多个模型以提高整体性能。

实验结果

- 通过在OAG-PST数据集上进行实验,提出的AWP、ConcatPool和模型集成方法在竞赛中取得了竞争性的排名。

- 加权集成方法在验证和测试数据上都取得了最高的分数,验证分数为0.43255,测试分数为0.41778。

MeiTuan

https://openreview.net/attachment?id=s2hVfSPTbU&name=pdf

方案概述

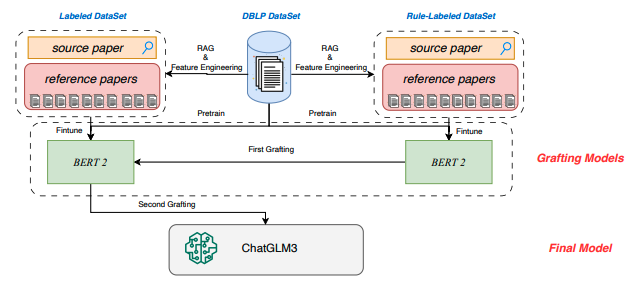

- 嫁接学习(Grafting Learning):这是一种新的迁移学习方法,适用于两个数据集数据分布不一致但预测目标一致,或者标签噪声分布不同的情况。通过在第一个数据集上训练模型,然后用该模型在第二个数据集上进行预测,将预测结果作为第二个数据集训练的额外特征。

- 特征工程和RAG:利用DBLP大规模知识图谱数据集中的辅助信息,构建了包括论文引用次数、发表年份、会议或期刊、摘要和关键词、前三位作者的名字和机构、作者和机构的总引用次数、会议或期刊的总引用次数等特征。

- BERT模型:在BERT模型训练中,采用了N-Gram Masked LM预训练任务、R-Dropout和TTA(Test-Time Augmentation)等技术以提高模型的稳定性和性能。

- LLM模型:使用生成式的CausalLM模型进行二分类任务,通过输入提示和有效信息后,指导模型输出单个标记("yes"或"no"),将分类任务转化为生成任务。

实验结果

- BERT模型的消融实验:通过在DBLP数据集上进行预训练、使用规则标注数据集进行第一次嫁接、加入R-Dropout和TTA技术,模型的MAP分数从0.4056提高到0.4701。

- LLM模型的消融实验:在第二次嫁接后,通过添加基于引用的辅助特征工程,最终单一模型分数达到0.5392,测试集分数为0.4813。

Zhejiang University

https://openreview.net/attachment?id=7jFSVWoZlI&name=pdf

方案概述

方案概述

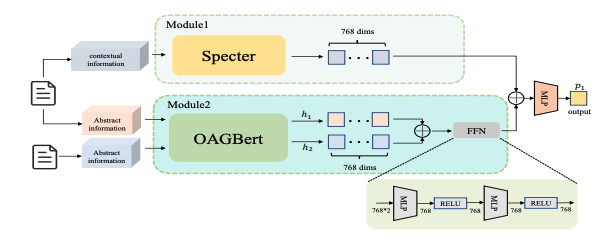

- 为了提高数据质量和准确性,考虑使用大型语言模型(LLMs)来清理和处理数据,但由于资源限制,目前使用基于规则的过滤技术来消除一些噪声数据。

- 采用双网络架构,将论文数据分为上下文和摘要两部分。上下文信息输入Module 1,生成768维嵌入向量。摘要信息输入Module 2,输入包括当前论文的摘要和引用论文的摘要,通过同一网络生成两个768维嵌入向量。

- 使用交叉熵损失函数来设计整体模型,以训练模型准确分类论文的源头状态。

实验结果

使用官方提供的788条标记记录的数据集进行训练,使用DBLP和OAG数据集获取论文的额外元数据。

与随机森林、ProNE和SciBERT等基线模型进行比较。使用MAP(平均精度均值)作为评估指标。

NJUST

https://openreview.net/attachment?id=Ov0EZ7PuuI&name=pdf

方案概述

- 论文追踪任务分为两个方面:基于BERT的文本分类任务和基于GCN的节点分类任务。

- 构建了参考标题信息、论文标题信息、论文摘要信息和论文上下文信息之间的关系网络,并利用GCN的强大关系建模能力进行节点分类。

实验结果

- 在BERT模型实验中,尝试了SCIBERT和CS_ROBERTA_BASE等模型,并进行了数据清洗和模型训练。

- 在GCN实验中,尝试了不同架构的GCN模型和不同的文本嵌入模型,并进行了图构建和模型训练。

NTT DOCOMO, INC.

https://openreview.net/attachment?id=FzfDN4ZJbY&name=pdf

方案概述

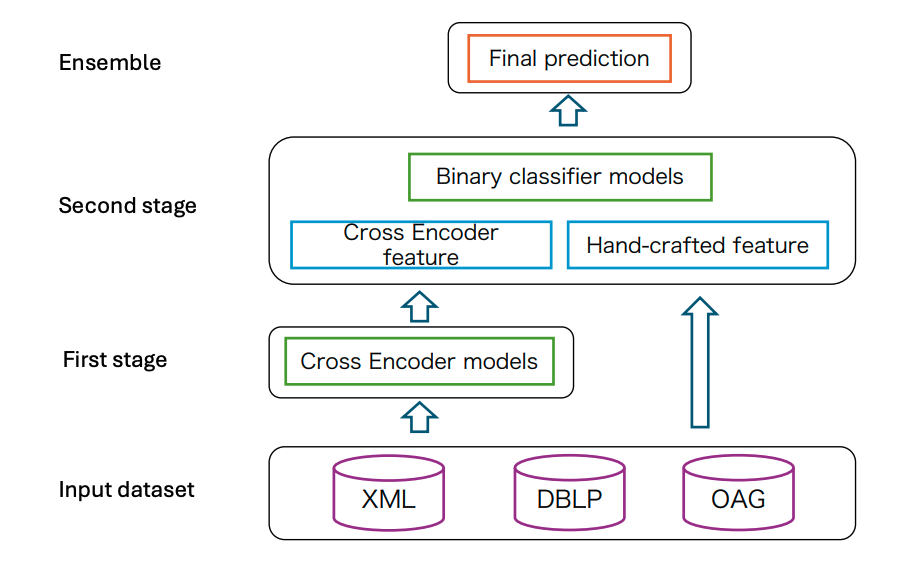

采用两阶段方法,第一阶段使用交叉编码器模型检测参考论文的相关性,第二阶段使用手工制作的特征和第一阶段的输出来训练多个二元分类器,最后通过集成方法聚合这些分类器的结果。

- 第一阶段:SciBERT集成的交叉编码器模型

- 第二阶段:二元分类器

实验结果

在Amazon EC2实例上进行实验,配备NVIDIA T4 Tensor Core GPU和16GB内存。

通过5折分组k折交叉验证进行离线评估,并在在线评估中展示了测试数据集的排行榜得分。